Q-LEARNING Content Feed

Wissens-Nuggets für zwischendurch

Nutzen Sie – wie in unseren Social Media Kanälen – die Kleinen Wissens-Nuggets rund um die Methoden- und Qualitätswelt. Der Content-Feed kann Trigger, Reminder, Aktivator sein für diverse Themen – und enthält Links zu weiteren Artikeln und Content-Formaten.

Sie können uns auch auf LinkedIn folgen: https://www.linkedin.com/school/q-learning/

HIGHLIGHTS

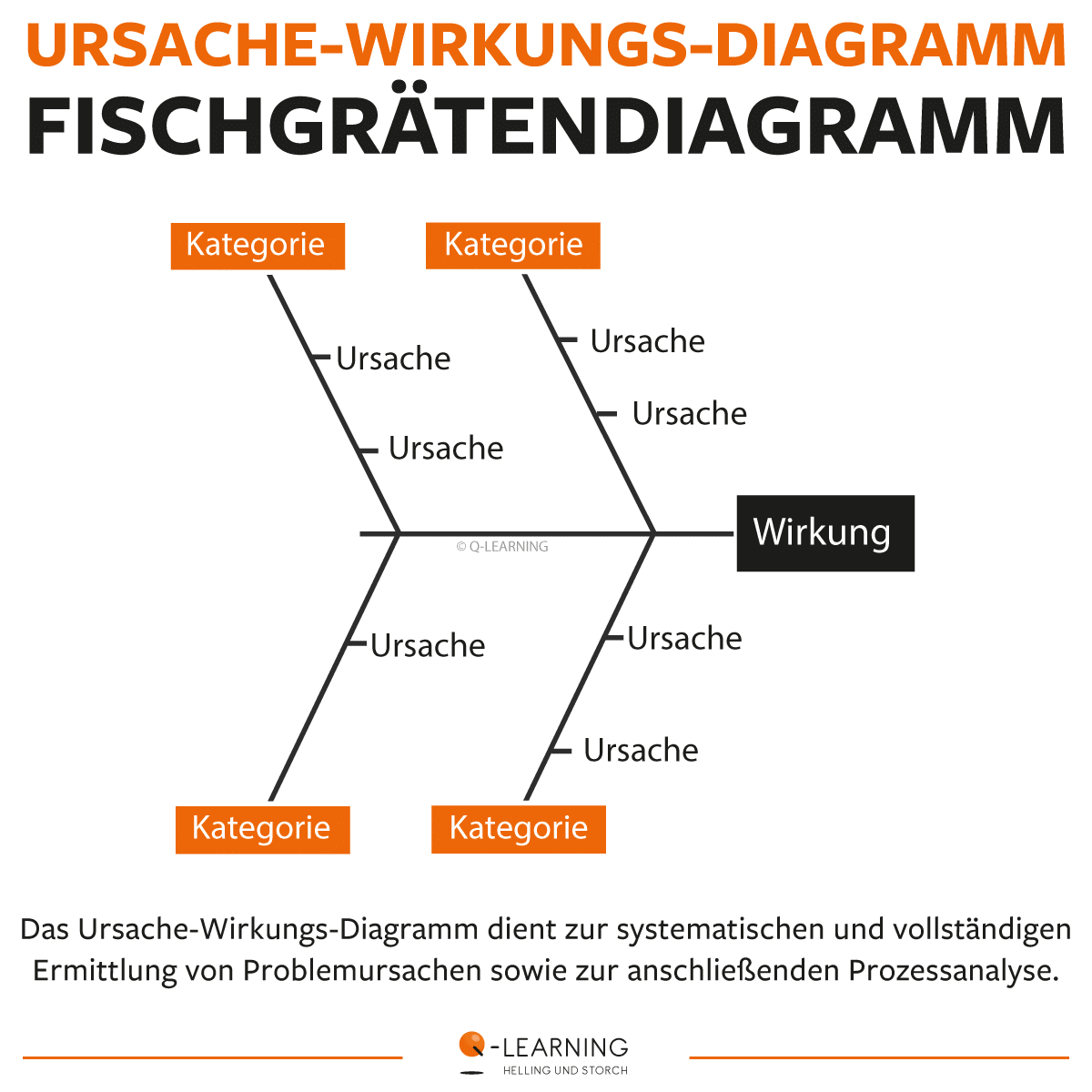

Die Kraft des Ursache-Wirkungs-Diagramms in der Problemlösung

Das Ursache-Wirkungs-Diagramm, auch als Fischgrätendiagramm oder Ishikawa-Diagramm bekannt, ist ein visuelles Tool, das dazu dient, die Ursachen eines bestimmten Problems oder einer bestimmten Situation zu identifizieren. Es wurde von Kaoru Ishikawa entwickelt und ist besonders nützlich im Rahmen von Qualitätsmanagement und Prozessverbesserung, wie es beispielsweise bei LEAN und SIX SIGMA angewendet wird. Hier ist eine kurze Erklärung, wie das Ursache-Wirkungs-Diagramm funktioniert:

1. Festlegung des Problems:

Beginnen Sie mit der klaren Definition des Problems, das Sie untersuchen möchten. Dies dient als der „Fischkopf“ des Diagramms.

2. Hauptkategorien identifizieren:

Zeichnen Sie eine horizontale Linie, die den „Fischkörper“ darstellt, und identifizieren Sie Hauptkategorien von potenziellen Ursachen. Diese Kategorien können je nach Kontext variieren, könnten jedoch Dinge wie Personal, Prozesse, Ausrüstung, Material und Umwelt umfassen.

3. Unterkategorien hinzufügen:

Von jeder Hauptkategorie aus erstrecken sich Linien (die „Gräten“) nach außen. Auf diesen Linien werden Unterkategorien oder spezifische Faktoren aufgeführt, die möglicherweise das Problem beeinflussen könnten. Diese Unterkategorien sind die potenziellen Ursachen des Problems.

4. Ursachen identifizieren:

Beginnen Sie, die Ursachen jeder Unterkategorie zu identifizieren. Dies kann durch Brainstorming und Analyse erfolgen. Die Idee ist, so viele potenzielle Ursachen wie möglich zu erfassen.

5. Zusammenhänge verstehen:

Verwenden Sie das Diagramm, um die Zusammenhänge zwischen verschiedenen Ursachen und dem Hauptproblem zu visualisieren. Dies ermöglicht es Teams, gemeinsam Ursachen zu diskutieren und zu verstehen.

6. Priorisierung:

Nachdem alle potenziellen Ursachen identifiziert sind, können Teams die wichtigsten und einflussreichsten Ursachen priorisieren. Dies erleichtert die gezielte Umsetzung von Maßnahmen zur Problemlösung.

7. Maßnahmen ableiten:

Basierend auf der Priorisierung können nun konkrete Maßnahmen abgeleitet werden, um die identifizierten Ursachen anzugehen. Dies führt zu einer gezielten und effektiven Problemlösung.

Das Ursache-Wirkungs-Diagramm fördert die teambasierte Ursachenanalyse und ermöglicht es, Probleme systematisch zu identifizieren und zu beheben. Es ist ein leistungsfähiges Werkzeug, um komplexe Zusammenhänge zu verstehen und verbesserte Lösungen zu entwickeln.

Wird die Qualität eines Prozesses ausschließlich in der Endkontrolle gemessen, kann das Ergebnis trügen! Denn die hier ermittelte „Erfolgsrate“ lässt interne Verluste – wie z. B. Nacharbeit – unberücksichtigt. Der Rolled Throughput Yield berücksichtigt diese sog. „versteckte Fabrik“ und rechnet anders:

Es werden die Erträge der einzelnen Schritte erfasst. Allerdings wird als Eingangsgröße für den nachfolgenden Schritt lediglich der Ertrag des vorangegangenen Schrittes genutzt.

Daraus ergibt sich der Gesamtertrag basierend auf den Teilen, die in allen Prozessschritten beim ersten Mal fehlerfrei erzeugt wurden.

Wozu das Ganze?

Unternehmen weisen Verbesserungspotenzial, welches die versteckte Fabrik birgt, im zweistelligen Prozentbereich (bezogen auf die Prozesskosten) aus. Ein lohnenswerter Ansatz also, zumal Methoden wie LEAN oder auch SIX SIGMA geeignet sind, hier systematisch anzusetzen.

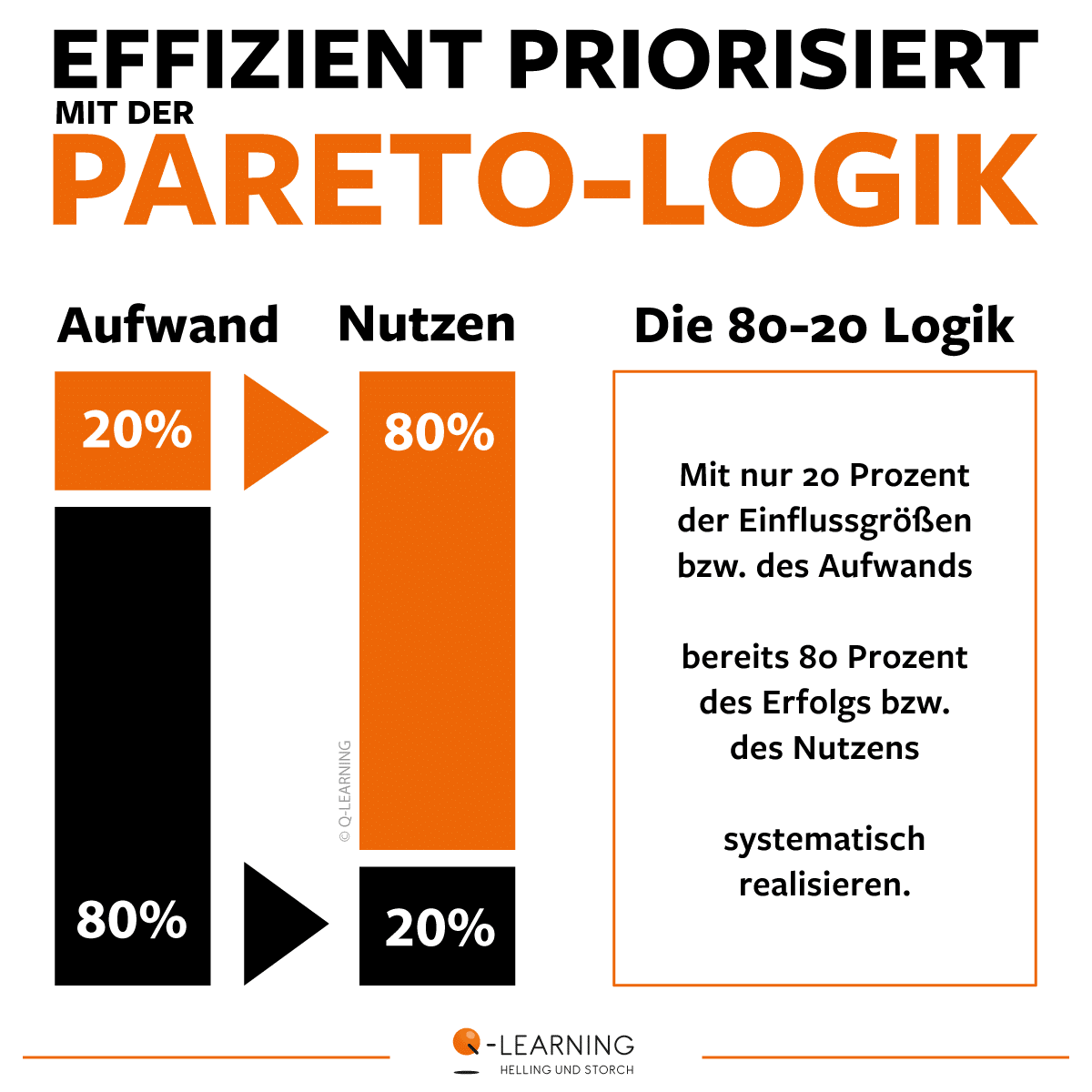

Im Projektgeschehen geht es um Effizienz und gute Entscheidungen:. Um dabei fundiert das Wichtige vom Unwichtigen zu trennen, ist das Pareto-Prinzip ein wichtiger Helfer.

Folgt man der auf Studien begründeten Argumentation von Vilfredo Pareto (1848-1923), sind es gewöhnlich 20 Prozent der Einflussgrößen (Aufwand), welche 80 Prozent des Erfolgs (Nutzen) ausmachen. Eine Erkenntnis, die seither als „Pareto-Prinzip“ anerkannt und als „80-20-Regel“ geläufig ist.

Auch SIX SIGMA bedient sich für die Prozessoptimierung des Pareto-Prinzips. Bbereits in der Projektdefinitionsphase („Define Phase“) kommt es filternd und lenkend zum Einsatz. Hier wird das Hauptproblem identifiziert. Das ist wichtig, um eine Vermengung von mehreren Problemen zu vermeiden, denn dies könnte die spätere Ursachenanalyse unscharf und unnötig aufwändig werden lassen.

Selbstverständlich reduziert sich die Anwendung des Pareto-Diagramms nicht alleine auf ein SIX SIGMA Projekt. In vielen anderen Problemlösungsmethoden ist das Pareto-Diagramm ein wichtiger Bestandteil. Ebenso ist Pareto beispielsweise wichtiger Helfer im Beschaffungsmanagement. Vor allem aber sind Paretos Lehren im volkswirtschaftlichen Kontext international verbreitet.

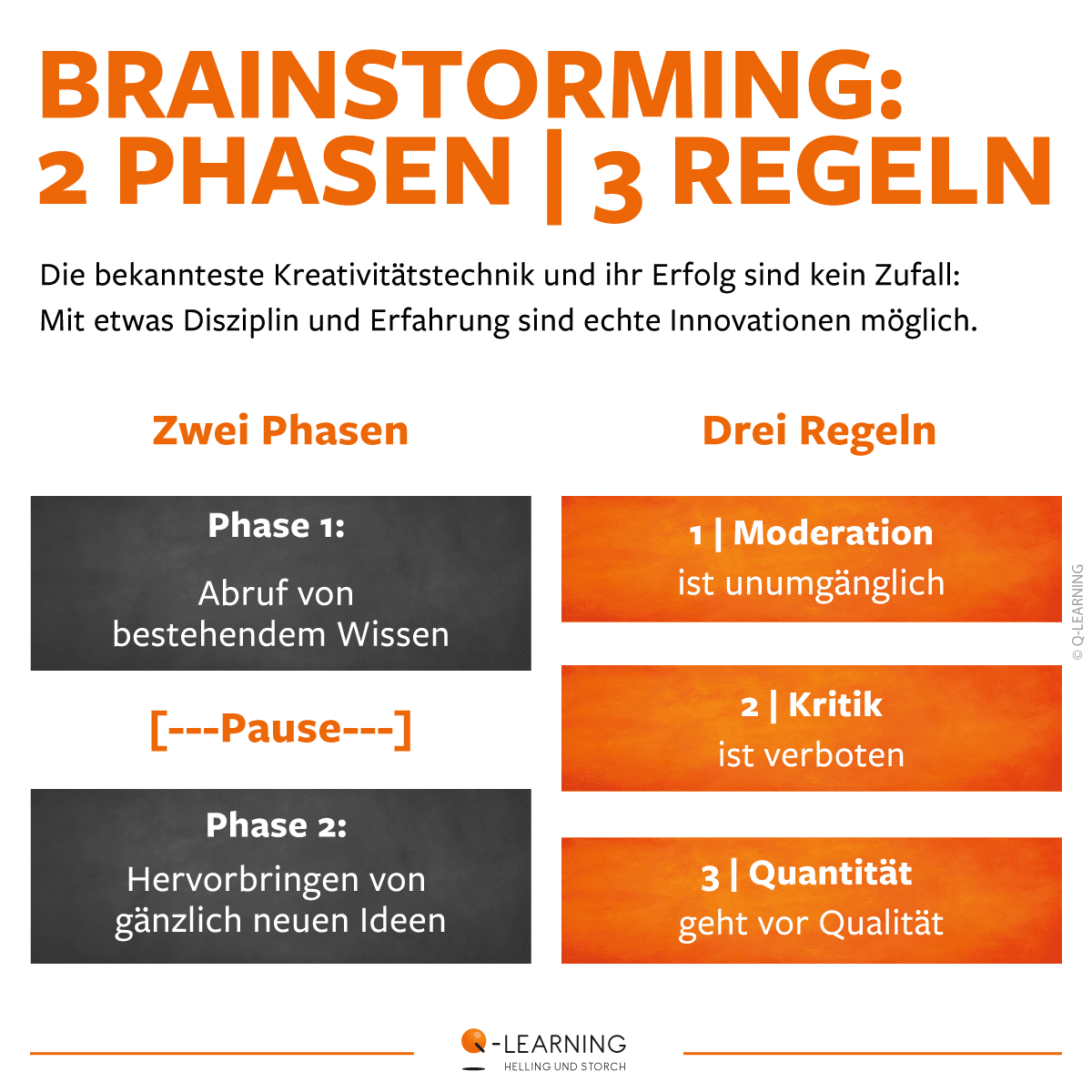

Brainstorming ist die wohl bekannteste und meistgenutzte Kreativitätstechnik. Sie dient primär der Sammlung von Ideen – beispielsweise um ein neues Produkt zu entwickeln oder ein Problem zu lösen. Für den Erfolg sind das Durchwandern zweier Phasen und die Beachtung dreier Regeln bedeutsam.

➡ Zwei Phasen

Ein Kreativprozess vollzieht sich in zwei Phasen.

🔸 Phase 1:

Sie fördert bestehendes Wissen zu Tage („Download von Erfahrungsschatz“).

🔸 Pause:

Nach einer natürlichen Pause, die es moderiert zu überbrücken gilt, folgt Phase 2.

🔸 Phase 2:

Sie ermöglicht frei-kreatives Denken und neue Ideen, außerhalb der gewohnten Denkrahmen.

➡ Drei Regeln

Kreativität braucht unbedingt ein paar Regeln:

🔸 1 | Stets mit Moderation! Ein erfahrener Moderator lenkt Teilnehmer und Kreativprozess in erfolgreiche Bahnen.

🔸 2 | Keine Kritik! Jegliche Kritik und Bewertung ist untersagt, jeder darf seine Vorschläge unzensiert einbringen.

🔸 3 | Quantität geht vor Qualität! Wilde Andersartigkeit ist erwünscht – ab an die Wand mit den Ideen! Denkrahmen sprengen!

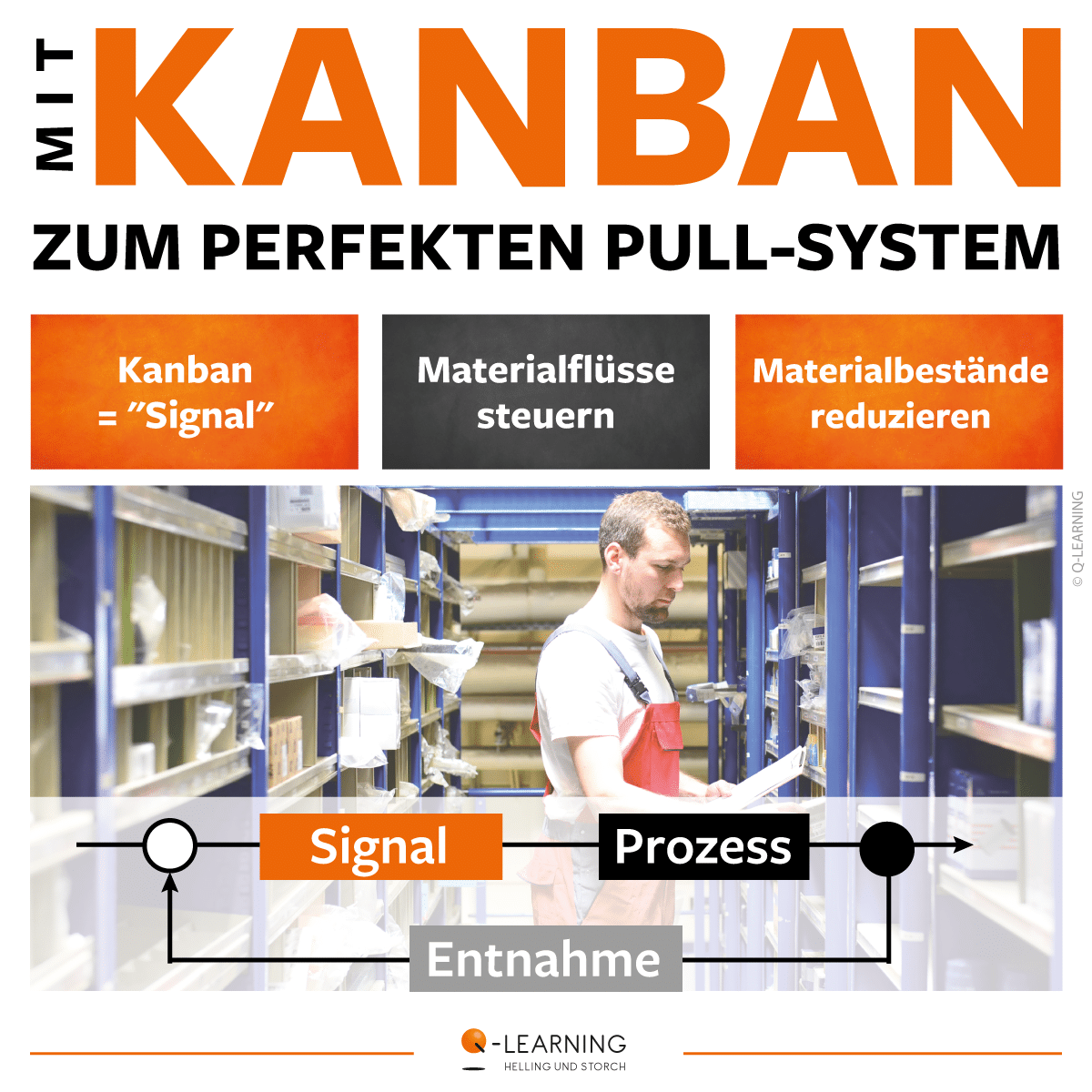

Material-Überbestände machen Prozesse träge, führen zu Fehlern und erzeugen hohe Kosten. Kanban ist die Methode, welche durch einfachste Prinzipien diese hohen Materialumlaufbestände reduziert.

Es wird genau analysiert, welcher Bestand notwendig ist. Dabei wird der sogenannte Sicherheitsbestand mit eingerechnet. Im nächsten Schritt wird festgelegt, wie viele Einheiten Material pro Zeiteinheit benötigt werden. Dabei orientiert man sich häufig an den kleinsten Transportkästen im Prozess. Nun ist geregelt, in welchen Abständen neues Material in den Prozess einfließen darf.

Was noch fehlt, ist eine Anpassung an Prozessschwankungen – und da kommt der Kanban als Signal ins Spiel. Erst wenn einem Kanban-Transportbehälter Material bis zu einem definierten Stand entnommen wurde, darf ein Kanban die Bereitstellung des nächsten Behälters auslösen. Das Prinzip kann auch auf die Anzahl der produzierten bzw. weiterverarbeiteten Artikel angewendet werden.

Damit ist der Materialfluss vollständig vom kundenseitigen Prozessende gesteuert. Das Pull-Prinzip, Materialfluss gesteuert durch Kundenabrufe, in Vollendung.

💡 Merke:

📌 Kanban ist eine hervorragende Methode, um Materialbestände zu reduzieren.

📌 Der Materialfluss wird vom Kunden her gesteuert (Pull-Prinzip).

📌 Wenige wichtige Regeln und Abläufe sind zu beachten.

📌 Verschwendung im Sinne von Überproduktion wird vermieden.

📌 Kanban ist ein mächtiges Hilfsmittel in Produktion, Logistik, Administration.

📌 Kanban ist die Grundlogik des agilen Projektmanagements zur Steuerung von Arbeitspaketen.

Weitere Hintergründe, Details und etwas Kontext ersehen Sie in unserem Magazin:

SIX SIGMA bedient sich zahlreicher Standardtools, so auch der „SMART-Formel“. Sie dient der klaren Definition der Projektziele und hat damit einen deutlichen Einfluss auf den Projekterfolg:

S | specific | spezifisch, präzise

M | measureable | messbar

A | attractive | attraktiv für Team, Unternehmen

R | reachable | realistisch, erreichbar

T | time-related | terminiert, zeitbezogen

Die SMART-Ziele finden Ihren Niederschlag im Projektvertrag sowie im Projektplan und ziehen sich damit als übergeordnete Anforderung durch das gesamte SIX SIGMA Projekt. Das gilt sowohl für den reaktiven DMAIC-Prozess als auch für den DMADV-Prozess des strategisch-entwickelnden DESIGN FOR SIX SIGMA Vorgehens.

Insbesondere die Messbarkeit und Erreichbarkeit sind im SIX SIGMA von zentraler Bedeutung, vielmehr ist sie gar eine methodeninhärente Eigenschaft. Aber auch die Präzisierung ist wesentlich, denn ein Projekt kann sich stets nur auf einen Hauptpfad konzentrieren (Pareto-Gedanke). Schlussendlich unterliegen auch SIX SIGMA Projekte mit ihrem DMAIC/DMADV-Projektmanagement einer straffen zeitlichen Planung und leben von einem motivierten Team das unbeirrbar auf die Projekt- und Unternehmensziele ausgerichtet ist.

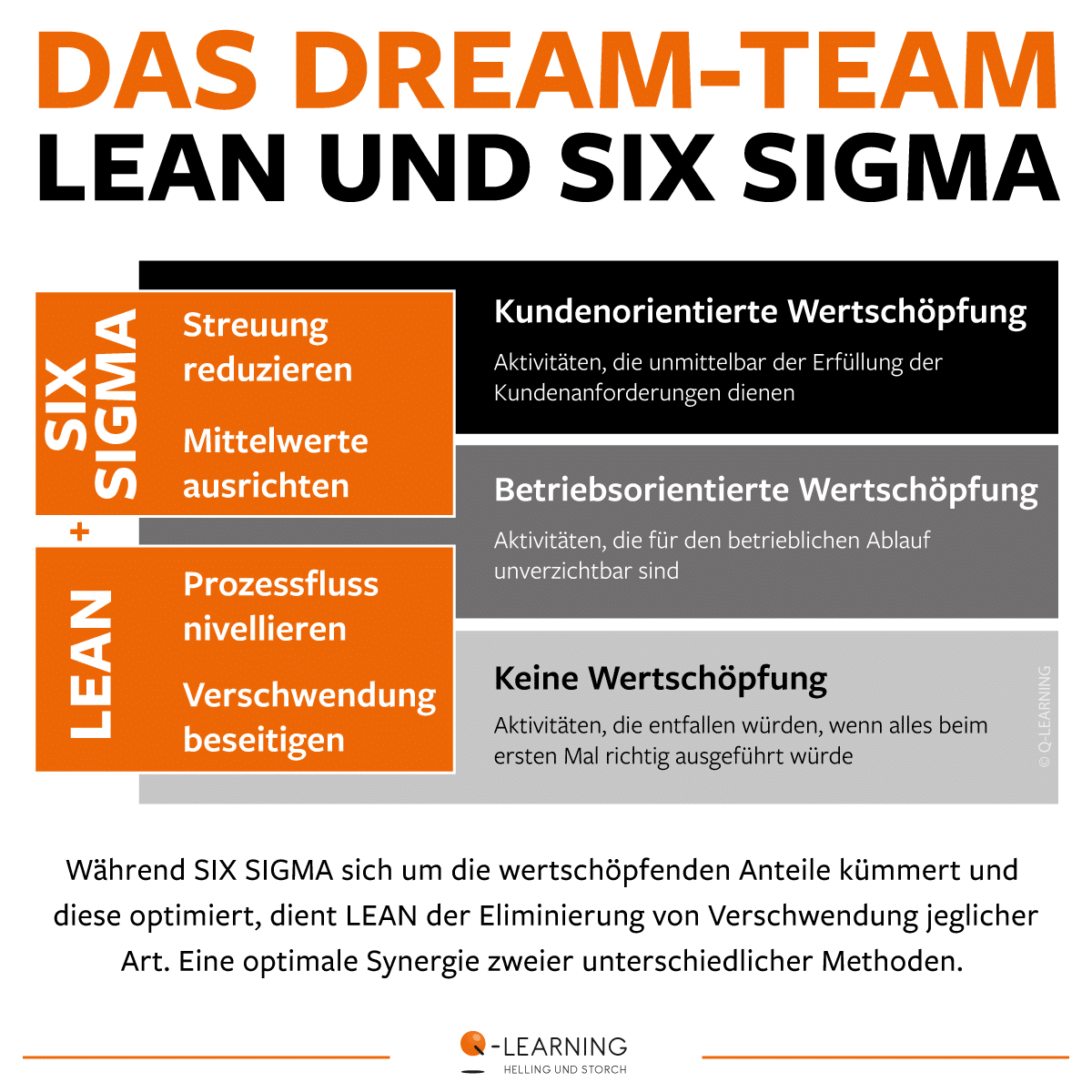

Der Erfolg von SIX SIGMA fußt nicht zuletzt auf soliden Hilfsmitteln und Tools des Qualitäts- und Prozessmanagements. Im DMAIC-Kontext sind diese Komponenten fester Bestandteil des stringenten Vorgehens. Aber sie können auch losgelöst daraus in Qualitäts- und Entwicklungsprojekten zur Anwendung kommen. Zu unterscheiden ist insbesondere zwischen teamorientierten und statistischen Vorgehensweisen.

Teamorientierte Tools: Sie machen das Expertenwissen von Einzelnen und der übergeordneten „Teamintelligenz“ nutzbar. Beispiele sind: Ist/IstNicht-Analyse, CTS-Tree, Brainstorming, Ishikawa / Fischgräte, Prio-Matrizen, Projektmanagement, Changemanagement

Statistische Tools: Sie basieren auf mathematischen Regeln und machen Zusammenhänge in Daten sichtbar. Beispiele sind: Regelkarten, Prozessfähigkeit, Korrelation, Regression, Hypothesentests, Varianzanalyse, Stat. Versuchsplanung, Toleranzrechnung

Übrigens: Auch einige Bestandteile von LEAN sind im SIX SIGMA genutzt, doch ist LEAN in Gänze eine eigenständige Methode mit eigenem Toolset.

Hin und wieder steht die Frage im Raum, ob die SIX SIGMA Methode noch in die Zeit passe. „Nicht kompatibel zu Industrie 4.0“ wird vorschnell behauptet. Aber wer SIX SIGMA und die Welt der Prozesse kennt weiß um die Stärken der Methode – gerade im Rahmen der aktuellen Industriellen Revolution.

🔎 Daten, Daten, Daten …

In Zeiten des (Industrial) Internet-of-Things treten große Datenmengen und deren Handling auf den Plan. Data Mining und statistische Methoden sind die Mittel der Wahl, um Sachverhalte zu verstehen, um Muster zu erkennen, um Rauschen zu filtern und um zielgerichtete Optimierungen in immer komplexeren Prozessen und Netzwerken vornehmen zu können.

🏁 SIX SIGMA fühlt sich wie zuhause!

Vor diesem Hintergrund von Datenverfügbarkeit und Komplexität ist es zu sehen, dass SIX SIGMA und seine Black Belt Experten:innen umso mehr gefragt und gebraucht sind. Sie sorgen mit ihrem systematischen Vorgehen für Fehlerfreiheit und – existenziell wichtige – Wirtschaftlichkeit und so erlebt die 1987 entwickelte Methode nach 35 Jahren einmal mehr einen Aufschwung.